Die Zeitschrift „Body Politics“ plant für 2018 ein Sonderheft zu Technik und deren Verhältnis zu Körperlichkeit zu untersuchen. Explizit angesprochen wird dabei die Digitalgeschichte in Hinblick auf die Computerisierung der Arbeitswelt. Hier fordern die Autoren zu Recht, ein Verlustnarrativ zu überwinden und neue Perspektiven zu erforschen. Abstracts können bis zum 15. Februar bei der Redaktion eingereicht werden.

Schlagwort-Archive: Computerisierung

Computer im Stall

In den späten 1960er-Jahren entwickelte sich der Computer zum Inbegriff der Modernität. Nachdem die Vorreiter wie die deutschen Banken und Sparkassen oder die Rentenversicherungen schon seit fast einem Jahrzehnt Computertechnologie nutzten, hielt er nun auch in immer breiteren Kreisen Einzug. Von den staatlichen Verwaltungen bis hin zur Landwirtschaft reichte sein Einsatz, wie ein interessanter Quellenfund aus dem Bundesarchiv veranschaulicht. In einer Sendung der UFA-Wochenschau präsentierte ein Sprecher vor schmissiger Musik, was die Landwirtschaft alles für ihre Modernisierung tue. Dabei finden sich Aufnahmen aus dem ersten Rechenzentrum Deutschen Zentrum für Tierzucht, in dem ein Computer die beste Paarung für die Rinderzucht berechnete. Dabei ist auffällig, in welche Linie der Computer hier gestellt wird. Rationalisierung und Industriemoderne waren Zauberworte des Computereinsatzes, dazu kam noch ein bisschen Dezentralisierung – und schon sahen die deutschen Bauern in der öffentlichen Meinung nicht mehr ganz so rückständig aus.

Text: Martin Schmitt

Quelle: BArch UFA-Dabei 647/1968, Filmarchiv des Bundesarchivs. Technische Daten: 35 mm, s/w. URL: https://www.filmothek.bundesarchiv.de/video/584837. Zuletzt abgerufen: 5.12.2016

Dank: Veronika Settele

Computerisierung auf dem Historikertag

Auf dem 51. Deutschen Historikertag in Hamburg ist unser Projekt gleich zwei Mal vertreten. Zum einen mit einem eigenen Panel unter Leitung von Frank Bösch am Donnerstagmorgen von 9-11 Uhr zum Thema „WEGE IN DIE COMPUTERGESELLSCHAFT. FOLGEN DIGITALER DATENERFASSUNG SEIT DEN 1950ER JAHREN“. Das Panel findet in Raum HWF-121 Hauptgebäude Westflügel statt. Zum anderen nimmt Projektmitarbeiter Martin Schmitt mit einem eigenen Poster zur „Digitalisierung der Kreditwirtschaft“ am diesjährigen Doktorandenforum.

Die Zukunft der Digitalgeschichte

Werden wir durch den Computer ersetzt?

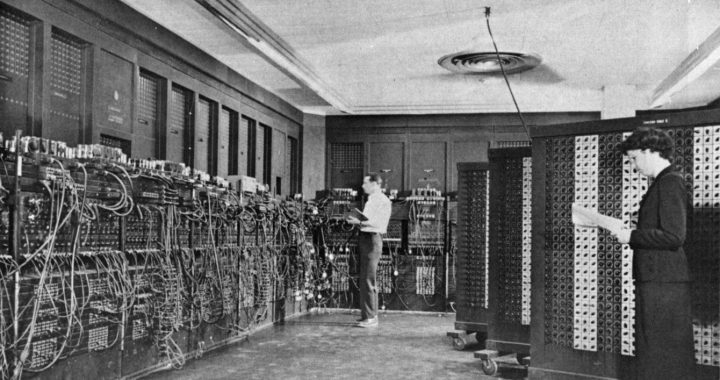

Die Frage, ob der Mensch durch den Computer ersetzt wird stellte sich den Zeitgenossen schon sehr früh. Vor allem in den Medien wurde diese Frage verhandelt, obwohl der Normalbürger noch lange nicht mit dem „Elektronengehirn“ selbst in Kontakt gekommen war. Hier wurden Erwartungen geweckt und Ängste geschürt, die später die Durchsetzung der Technologie begleiten sollten.

Ein schönes Beispiel für die mediale Auseinandersetzung mit der frühen Computertechnologie ist der Hollywood-Film „Desk Set“ aus dem Jahr 1957, in der sogar Katherine Hepburn mitspiele.Weiterlesen

Der Computer als Leitmedium

»Unleugbar hat sich mit der Evolution der Neuen Medien die Frage nach ihrem epistemologischen Ort zugespitzt. Erst mit dem ubiquitären Siegeszug in beinahe allen gesellschaftlichen Bereichen wurde seine Bestimmung, als universelles bzw. inklusives Medium die vormals getrennten Einzelmedien dank der digitalen Codierbarkeit integrieren zu können, tragfähig. Und mit der Verbreitung des ›persönlichen‹ Computers wurde darüber hinaus seine Funktion als neues Leitmedium zum dominanten Thema sowohl der Medienskepsis als auch der Medieneuphorie.«

Tholen, Georg Christoph (2002), Die Zäsur der Medien: Kulturphilosophische Konturen, Frankfurt a.M.: Suhrkamp. S. 19.Weiterlesen

Computerisierung auf der Langen Nacht der Wissenschaften

Über Wissenschaft in der Öffentlichkeit und unser Forschungsprojekt bei der „klügsten Nacht des Jahres“ in Berlin. Von Martin Schmitt

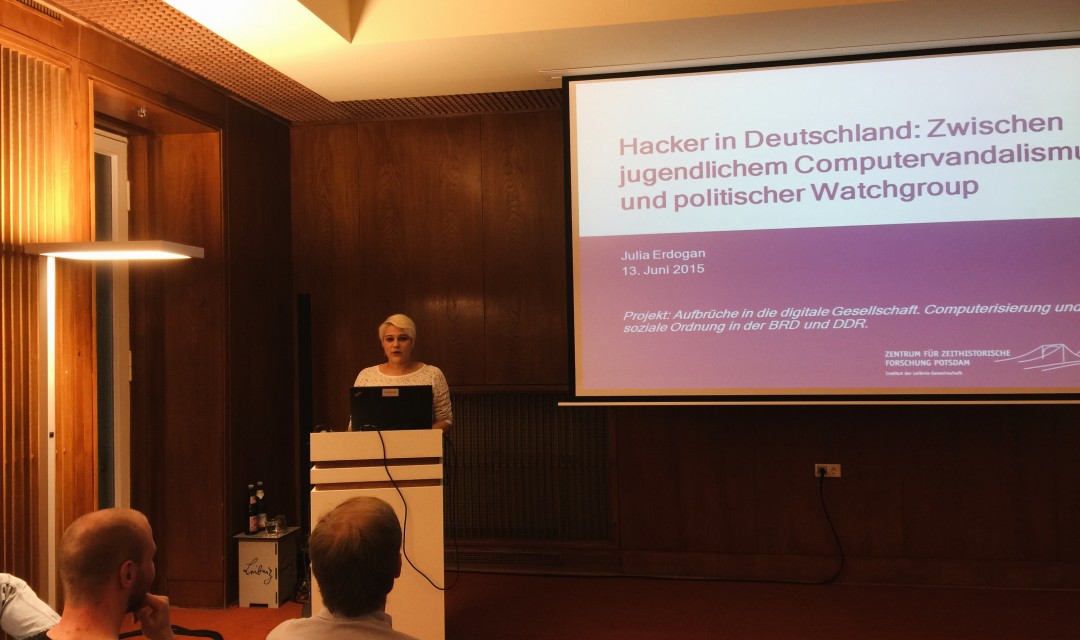

Auf der Langen Nacht der Wissenschaften, die am Sonntag dem 13. Juni in Berlin und Potsdam stattfand, stellte unsere Projektmitarbeiterin Julia Erdogan der interessierten Öffentlichkeit unser Gesamtprojekt und ihr Teilprojekt zu den Hackern in Deutschland vor. Im historischen Gebäude des Naturkundemuseums, in dem sich die Institute der Leibniz Gemeinschaft präsentierten, verdeutlichte sie die historische Entwicklung von Hackern und deren öffentlicher Wahrnehmung zwischen Watchgroup und krimineller Bedrohung. Es gelang den Hackern in Deutschland seit den 1980er-Jahren durch zahlreiche öffentlichkeitswirksame Aktionen nicht nur, auf die Sicherheitslücken der Computersysteme aufmerksam zu machen, sondern zugleich dazu beizutragen, die positive Schaffenskraft des Computers in einer demokratischeren Gesellschaft zu etablieren. Zerstörerische Elemente der Hackerhandlungen deutete Julia Erdogan mit Schumpeter als konstruktiver Erneuerungsfaktor und damit als kreatives Element. Hacker seien bis heute eine sehr heterogene Gruppe, welche die Lust am Handeln mit und durch den Computer charakterisiere.

Neben Fragen zur generellen Ausrichtung des Projektes identifizierten sich das Publikum stark mit der historischen Computerentwicklung und schwelgte in Erinnerung an die erste verschickte Mail und den ersten Computer. Aber auch kritischere Fragen bewegten die anwesenden Bürger und Bürgerinnen: Wie viele Hacker gab es denn überhaupt in Deutschland? Und wie war ihre Situation in der DDR? Gab es einen Linux-Zwang unter den Hackern, also folgten sie nicht selbst einer normierenden, standardisierenden Subkultur?

Julia Erdogan und mit ihr das Projekt zur Computerisierung in BRD und DDR erzeugten ein großes öffentliches Interesse und trugen zu einer gelungenen langen Nacht der Wissenschaften in Berlin bei, auf der sich die Wissenschaft in all ihren Facetten zeigte. Zu sehen waren computertechnologischen Neuerungen in den T-Labs der TU Berlin über die vielfältigen Erfahrungsangebote wissenschaftlicher Produkte wie in der Hochspannungshalle des Institutes für Energie- und Automatisierungstechnik oder den Berliner Bibliotheken bis hin zu Science Slams als locker aufbereitete Ergebnispräsentation.

Höhepunkte der Langen Nacht war dann neben dem Feuerwerk der gemeinsame Science Slam der TU Berlin, der UDK und der HDK im komplett vollen Audimax der TU-Berlin. Ihn gewann der spontan eingesprungene Tobias Hölzer mit einem humorigen Slam über die Zukunft des Computings. Er zeigte an Hand einer Dating-Situation zwischen Mann und Frau die Funktionsweisen moderner Quantencomputer. Aus Computerisierungs-Perspektive war daran vor allem die Annahme spannend, die gesamte soziale wie auch physische Welt als berechenbar anzusehen – wenn man nur den ausreichend leistungsfähigen Computer dazu hat. Die Forschung an den Quantencomputern stehe noch sehr am Anfang, betonte Hölzer. Aber die Entwicklungen seien rapide. Als Anwendungsgebiete sieht er vor allem Big-Data-Suchen, ausgefeilte Simulationen der Welt, bis hin zu unknackbarer Kryptografie, beispielsweise für Geheimdienste. Es ist spannend, was in den nächsten Jahren hier auf uns und die Gesellschaft zukommen.

Insgesamt besuchten fast 27.000 Besucher die Lange Nacht der Wissenschaften in Berlin. Sie bekamen einen Einblick in die Welt der Wissenschaften, der ihnen all zu häufig verschlossen bleibt und nahmen ein Stück der Begeisterung mit nach Hause, mit der vor allem die jungen Wissenschaftler mit leuchtenden Augen von ihren Projekten erzählten.

Autor: Martin Schmitt

Bildrechte:

Dieses Werk von Martin Schmitt ist lizenziert unter einer Creative Commons Namensnennung – Nicht-kommerziell – Weitergabe unter gleichen Bedingungen 4.0 International Lizenz.

Die Verdatung der Welt

Forschung macht man nicht alleine. Vor allem nicht in einem so umfassenden Feld wie dem der Geschichte der Computerisierung. Das ist auch gut so, denn unser Projekt mit fünf Mann/Frau könnte die Fülle der Themen überhaupt nicht bearbeiten. Darum freuen wir uns immer wieder zu merken, wie viele spannende Projekte im Moment im Umfeld der Zeitgeschichte der Informationsgesellschaft entstehen. Und auch auf großen medialen Konferenzen wie der re:publica 2015 spielt die Geschichte der Computerisierung eine zentrale Rolle, enorm häufig wurde dort in den Beiträgen computerhistorisch argumentiert oder war die Geschichte des Digitalen Zeitalters selbst Gegenstand.

Aus diesem Grund soll in unserem Projektblog unter der Kategorie „Literaturhinweis“ auch immer wieder auf spannende Projekte und Publikationen verwiesen werden, die an anderen Instituten und Universitäten entstehen. Ein Anfang macht die Dissertation von Julia Fleischhack, „Eine Welt im Datenrausch: Computeranlagen und Datenmengen als gesellschaftliche Herausforderung in der Bundesrepublik Deutschland, 1965-1975“, die 2012 an der Universität Zürich abgeschlossen wurde und die Ende Juni 2015 erscheinen soll. Hier ein Auszug aus der Projektbeschreibung. In ihrer Dissertation verfolgte Frau Fleischhack

„… in erster Linie die Frage, wie der gesellschaftliche Umgang mit Daten zu einem zentralen Konfliktfeld des späten 20. Jahrhunderts wurde. Im Fokus stand mit den 1960er und 1970er Jahren die Frühphase der ›Computerisierung‹ in der Bundesrepublik Deutschland: Untersucht wurden u.a. neben der Entstehung(sgeschichte) der ersten Rechenzentren und den großangelegten Vernetzungsplänen und -visionen zum Datenaustausch in der öffentlichen Verwaltung auch die Ausweitung des Datenhandels und speziell der Datenerfassung von Personen im kommerziellen Bereich.“ (UZH, zuletzt abgerufen am 10.05.2015)

Autor: Martin Schmitt

Bildrechte: Charis Tsevis, under CC 2.0

Ersetzen Computer den Historiker? (Teil 1)

Plötzlich stehen auch die kreativen Berufe scheinbar zur Disposition. Sind jetzt auch die Historiker dran? Die Debatte darüber ist entbrannt. “Can computers replace historians?” fragt Rory Cellan-Jones in der BBC. Seine Antwort ist “Nein” – seine Frage aber Teil einer Debatte, die auch die Geschichtswissenschaft nicht unberührt lassen wird.

Der Computer ist für den Historiker ein nicht mehr wegzudenkendes Werkzeug. Geeignete Software ordnet Literatur und Archivmaterialen, mit Textverarbeitungsprogrammen werden wissenschaftliche Artikel und Monographien angefertigt und das Internet ist das Tor zu einer ungemeinen Fülle an Informationen. In einer klassischen Geschichtswissenschaft sind diese Tools vollkommen ausreichend, um eine qualitativ hochwertige Arbeit anzufertigen. Darüber hinaus gibt es aber noch ein weiteres Feld, in dem viele Historiker derzeit noch nicht bewandert sind: Es heißt Big Data.

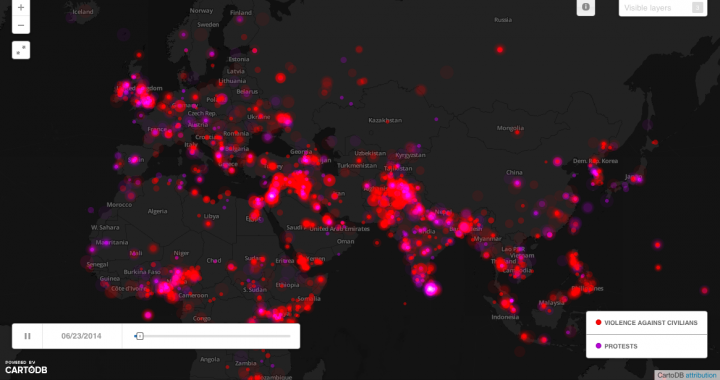

Mit der Bedeutung von Big Data für den Historiker beschäftigt sich der Tech-Journalist Rory Cellan-Jones in einem kürzlichen erschienen BBC-Artikel. Ausgangspunkt war für ihn die Studie von Kalev Leetaru, einem Spezialisten für Big Data an der Georgetown University. In historischen Daten Muster zu erkennen, die dem menschlichen Auge verborgen bleiben, das ist der Traum von Leetaru. Die Software, die er dafür verwendet hat, ist durchaus interessant. Das Tool heißt Google Big Query und ist in der Lage, extrem große Mengen an Daten zu sammeln und aufzubereiten. Kalev Leetaru sichtete Daten bis zum Jahr 1979 und speiste sie in die Software ein. Für letzten 35 Jahre und für die Zukunft übernahm die Software GDLET die Arbeit, indem sie Daten aus verschiedenen Quellen sammelte und strukturierte – von Medienberichten über Wirtschaftsstatistiken bis hin zu Regierungserklärungen in über 100 Sprachen. Was Leentaru mit Hilfe der Software in den Daten sah, sind wiederkehrende Muster. So analysierte er die Ereignisse in der Ukraine, Ägypten und den Libanon und behauptet, Gemeinsamkeiten festzustellen. Ein gutes Beispiel hierfür ist eine Karte, auf der zwei Faktoren in ihrer zeitlichen und räumlichen Entwicklung dargestellt werden: Gewalt gegen die Zivilbevölkerung und Demonstrationen. Leetaru geht aber noch einen Schritt weiter. Er behauptet, den späteren Verlauf der Ereignisse mit den zuvor gewonnen Daten bestimmen zu können, wie er in sinem Blog darlegt. So braucht es nur extrem viele Daten, etwas Statistik und einen guten Algorithmus und schon können wir Weltgeschehnisse besser einschätzen. In nur 2,5 Minuten, so heißt es, wäre es möglich, eine ganze Liste von Perioden in der “World History” der letzten 35 Jahre darzustellen, die Ähnlichkeiten zu den zentralen Monaten der Revolution in Ägypten aufweisen. Der Rest sind Korrelationen. Für die Auswertung braucht es mehr als nur Anfängerwissen in Statistik.

Was bedeutet diese Entwicklung für Historiker? Natürlich werden wir nicht ersetzt. Es werden aber unsere bisherigen Methoden und Herangehensweisen in Frage gestellt. Besonders interessant ist dies vor allem für Zeithistoriker und Historiker der “World History”. Hier werden in den letzten Jahrzehnten eine Unmenge von Daten gesammelt, die digital zur Verfügung stehen. Es sind Tools notwendig, um eine erste Selektion vorzunehmen. Algorithmen können dabei ein Hilfsmittel sein, um Trends zu erkennen, ohne die qualitatative Analyse der Quellen aufzugeben. Auch große Datenmengen müssen im Vorfeld systematisiert werden, ebenso wie das Ergebnis der Software einer historischen Deutung bedarf. Das ist und bleibt die Aufgabe gut ausgebildeter HistorikerInnen und kann durch keinen Computer ersetzt werden. Voraussagen für die Zukunft überlassen wir aber vielleicht besser der Software.

Die dahinterliegende Debatte, ob die Maschine den Menschen eines Tages ersetzen werde, reicht hingegen weiter zurück. Im zweiten Teil, der in wenigen Tagen folgt, wird diese Debatte eingeordnet in die längeren Linien der Computerisierung und der Debatte um künstliche Intelligenz.

Autoren: Janine Noack, Martin Schmitt

Bildquelle: Screenshot des GDELT Global Conflict Boards